動画コンテンツの需要が爆発的に増加する中、従来の「手作業による編集」では制作スピードが追いつかない場面が増えています。エンジニアやテクニカルディレクターがいま注目すべきは、生成AIを活用したエンジニアリングプロセスの自律化です。

本記事では、Googleの最新IDE「Google Antigravity」を司令塔とし、Reactベースの動画エンジン「Remotion」、そしてAlibaba Cloudの最新音声合成モデル「Qwen3-TTS」を組み合わせた、最先端のエージェンティック・クリエイティブ・オートメーション(自律型動画生成システム)の構築手法を徹底解説します。

なぜ今、「エージェント主導型」の動画生成なのか?

従来の自動化 vs エージェント主導開発

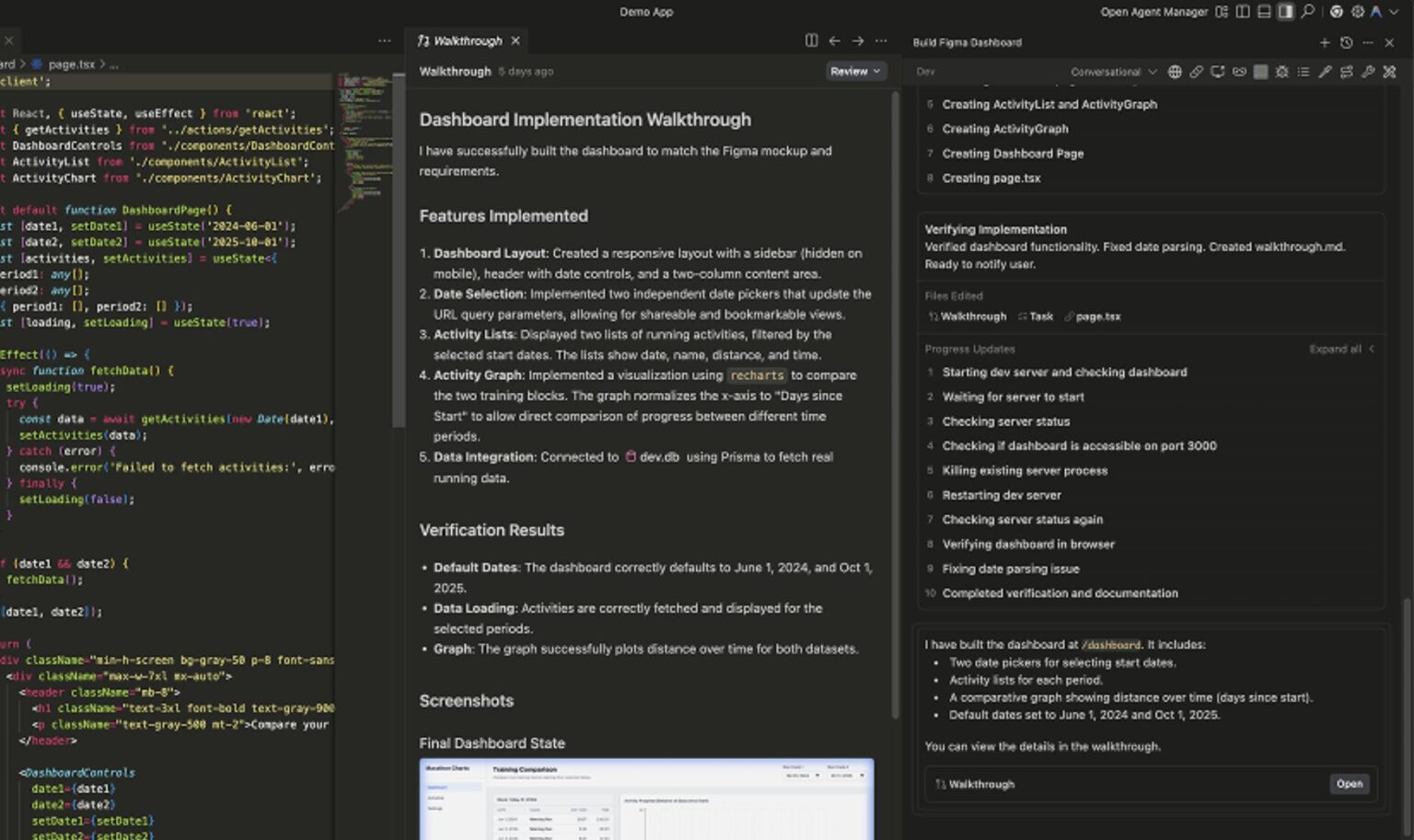

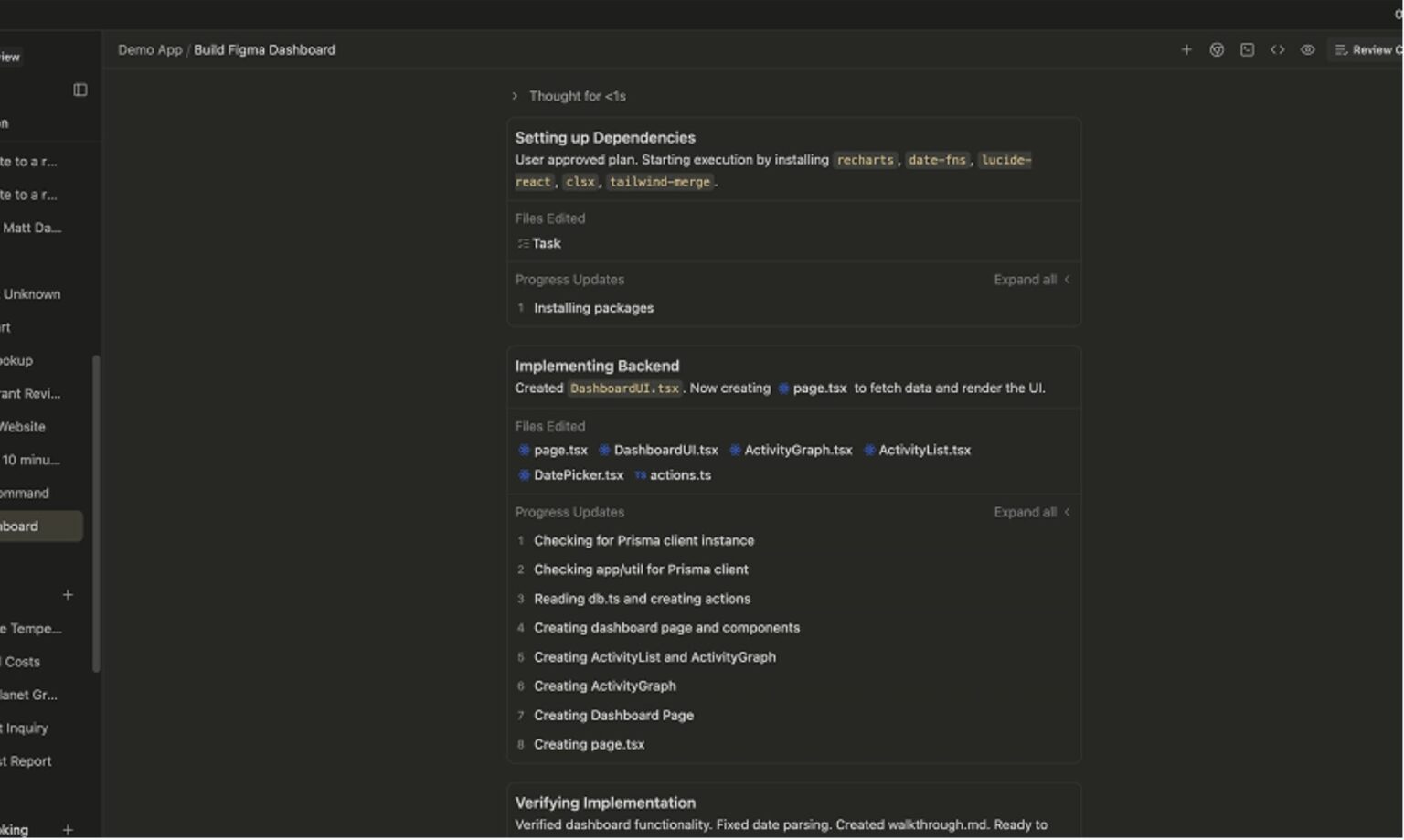

これまでの「Programmatic Video(プログラムによる動画生成)」は、エンジニアがボイラープレート(定型コード)を手動で管理し、APIをつなぎ合わせる必要がありました。しかし、Google Antigravityの登場により、開発環境自体が「エージェント」として振る舞い、以下のタスクを自律的に遂行できるようになりました。

- 環境構築の自動化: 複雑な依存関係の解決

- API統合: ドキュメントを読み込んでの実装

- デバッグ: エラーの自動検知と修正提案

これにより、開発者は「コードを書く」作業から、「どのような動画を作るか」という**アーキテクチャの設計(監督)**へと役割をシフトできます。

採用する技術スタックの選定理由

本システムでは、以下の3つの技術が高いシナジーを発揮します。

| カテゴリ | 採用技術 | 選定理由・役割 |

|---|---|---|

| 司令塔 (Orchestrator) | Google Antigravity | Gemini 3 Pro等を内包し、コード生成からデプロイまでを自律的に行う開発基盤。Remotionのプレビュー環境立ち上げも自動化可能。 |

| 映像エンジン (Renderer) | Remotion | React/Web技術で動画をフレーム単位でレンダリング。DOM操作が可能で、テキストやアニメーションの動的制御に最適。 |

| 音声エンジン (Voice) | Qwen3-TTS | 低遅延かつ表現力豊かな最新音声合成モデル。49種類以上の感情表現が可能で、日本語を含む多言語に対応。 |

Google Antigravityによる開発環境の構築

まずは、エージェントが活動するための基盤を整えます。

インストールと権限設定

Google Antigravityをインストール後、重要なのがエージェントの権限設定です。動画生成パイプラインではnpmコマンドやffmpegの操作が頻繁に発生するため、初期構築時は「Turbo Mode」(自動実行モード)を活用すると効率的です。

プロジェクト構造のベストプラクティス

Antigravityはワークスペースごとにエージェントの記憶(メモリ)を保持します。以下のようなディレクトリ構造を推奨します。

~/projects/ai-video-generation/

├── .antigravity/ # エージェント設定・記憶

├── src/ # Remotion (React) ソースコード

├── scripts/ # Python自動化スクリプト (TTS, データ処理)

└── assets/ # 生成された音声・画像ファイル

エージェントへの「知識注入」

エージェントに最新の仕様を理解させるため、「Knowledge Graph」に以下の公式ドキュメントURLを登録します。これにより、ハルシネーション(嘘の生成)を防ぎ、正確なコードを生成させることができます。

- Remotion Docs

- Qwen3-TTS API Guide (Alibaba Cloud)

Qwen3-TTSによる高品質なナレーション生成

動画の質を左右する「音声」には、Qwen3-TTS(Flashモデル)を採用します。このモデルは、呼吸音や間(ポーズ)まで再現する人間らしい表現力が特徴です。

PythonによるTTSジェネレーターの実装

Antigravityのエージェントに指示し、以下の機能を持つPythonクラスを作成させます。

- API連携: DashScope SDKを使用した音声合成

- キャッシュ機能: 同じテキストなら再生成せず、APIコストと時間を節約

- メタデータ取得: 動画編集に必要な「音声の秒数(Duration)」を正確に計測

実装コード例(抜粋)

# scripts/generate_tts.py の一部

def generate(self, text: str, voice: str = "Cherry") -> Dict:

# ... (ハッシュ生成やキャッシュ確認のロジック)

# DashScope API呼び出し

result = dashscope.MultiModalConversation.call(

model="qwen3-tts-flash",

text=text,

voice=voice, # "Cherry", "Ethan" などキャラクター指定

format='mp3'

)

# 音声の長さを正確に取得 (pydub使用)

audio = AudioSegment.from_mp3(file_path)

duration = len(audio) / 1000.0

return {

"text": text,

"audio_src": relative_path,

"duration_sec": duration

}

ボイスキャラクターの使い分け

ターゲット層に合わせてボイスを選定しましょう。

- Cherry: 親しみやすい女性の声(解説動画、ナレーション向け)

- Ethan: 力強い男性の声(テックレビュー、製品紹介向け)

- Serena: 穏やかな女性の声(教育、ヒーリング向け)

Remotionによるデータ駆動型動画レンダリング

音声ができたら、Remotionを使って映像を組み立てます。ここでのポイントは、「Data-Driven(データ駆動)」な設計です。

JSONデータによる動画構成

Pythonスクリプトが出力したdataset.jsonをRemotionが読み込みます。このJSONには、各シーンのテキスト、音声パス、秒数、背景色などが定義されています。

[

{

"id": "scene_01",

"text": "こんにちは、AI動画生成の未来へようこそ。",

"audio_src": "/audio/hash_12345.mp3",

"duration_sec": 4.52,

"bg_color": "#1a1a1a"

}

]

Reactコンポーネントでの動的制御

Remotionの<Series>コンポーネントを使用すると、配列データに基づいてシーンを自動的に連結できます。前のシーンが終わった瞬間に次のシーンが始まるよう、手動でタイムラインを調整する必要はありません。

// src/MainVideo.tsx

export const MainVideo = ({ data }) => {

return (

<Series>

{data.map((scene) => (

<Series.Sequence key={scene.id} durationInFrames={scene.duration_sec * 30}>

<SceneComponent text={scene.text} audio={scene.audio_src} />

</Series.Sequence>

))}

</Series>

);

};

応用:Matter.jsによる「Antigravity」な物理演出

記事タイトルやプロジェクト名にちなみ、Matter.js(物理演算エンジン)を導入して、重力に逆らうようなリッチな視覚効果を追加する方法も紹介します。

「Baking(焼き込み)」テクニック

Remotionのレンダリングは「常に同じ結果(決定論的)」である必要がありますが、物理演算は実行ごとに微妙に結果が変わります。これを解決するために、事前に物理シミュレーションを実行し、座標データをJSONに保存(Baking)する手法をとります。

これにより、Qwen3-TTSの音声に合わせてテキストが物理法則に従って落下したり、浮遊したりする高度なアニメーションが可能になります。

完全自動化へのワークフロー統合

最後に、これら全ての工程をAntigravity上の「スキル(Skill)」として統合します。

「Director Mode」の実装

チャット一発で動画を生成できるよう、以下のようなタスクフローを定義します。

- Intent Analysis: ユーザー指示「テックニュースの動画を作って」

- Resource Gathering: エージェントがWeb検索でニュース収集

- Asset Generation: Qwen3-TTSで音声化&物理データ生成

- Rendering: Remotionプレビューの起動

実際の操作イメージ

Antigravityのチャット欄で以下のように入力するだけです。

User: 「最新のAIトレンド記事を3つ要約して、Cherryの声で解説動画を作って。物理エフェクトも入れて。」

Agent: 「了解しました。RSSフィードを取得し、スクリプトを作成します...(Python実行中)...(Remotionプレビュー起動)...完了しました。」

まとめ:動画制作は「編集」から「生成」へ

Google Antigravity、Remotion、Qwen3-TTSを組み合わせることで、動画制作は労働集約的な作業から、クリエイティブなディレクション業務へと変貌します。

このシステム構築は一見複雑に見えるかもしれませんが、Antigravityのエージェント機能を使えば、コードの大部分はAIが補完してくれます。ぜひこの構成を参考に、あなただけの「自律型AI動画スタジオ」を構築してみてください。